Le processus de Validation¶

Consiste à évaluer la capacité d’un réseau spécialisé à effectuer de bonnes prédictions. Pour ce faire, le processus de validation évalue quantitativement l’*écart entre la prédiction du réseau et l’attente experte* sur des jeux de données annotées.

En première approximation¶

Les indicateurs retenus utilisés par la plateforme sont le F-mesure (F), le Rappel (R) et la Précision (P).

Le F-mesure est le meilleur compromis entre Précision et Rappel, deux indicateurs évaluant respectivement l’erreur par excès et l’erreur par défaut de la prédiction du réseau. La Précision donne la proportion de prédictions trouvées pertinentes (mesure la capacité du système à refuser les prédictions non-pertinentes), le Rappel la proportion des prédictions pertinentes trouvées (mesure la capacité du système à donner toutes les prédictions pertinentes). Du point de vue pratique, le F-mesure est la moyenne harmonique de la Précision et du Rappel : il estime donc la capacité du système à donner toutes les prédictions pertinentes et à refuser les autres.

De manière plus détaillée¶

Les processus de validation évaluent (et donnent) des indicateurs statistiques supplémentaires, notamment l’ Erreur (E) et l’ Accuracy (A). Ces indicateurs sont tous des rapports spécifiques entre effectifs des classes Vrais Positifs (VP), Faux Positifs (FP) et Faux Négatifs (FN) déduits de la matrice de confusion.

Les Vrais Positifs regroupent les prédictions trouvées à raison, i.e. celles qui correspondent à des annotations expertes. Les Faux Positifs sont les prédictions trouvées à tort, i.e. celles ne correspondant à aucune annotation experte. Enfin les Faux Négatifs sont les annotations expertes pour lesquelles le réseau n’a rien prédit.

La cerise sur le gâteau : la matrice de confusion multi-classes¶

La matrice de confusion M est une matrice qui mesure la qualité d'un système de classification. Chaque ligne correspond à une classe réelle, chaque colonne correspond à une classe estimée. La cellule M i,j contient le nombre d'éléments de la classe réelle i qui ont été estimés comme appartenant à la classe j.

De ce fait, on détermine les Vrais Positifs, Faux Positifs et Faux Négatifs de la classe i comme suit :

Un des intérêts de la matrice de confusion est qu'elle montre rapidement si un système de classification parvient à classifier correctement.

En pratique¶

Le processus de validation prend en entrée un ensemble de données annotées et fournit en sortie les informations numériques et visuelles caractérisant l’écart entre la prédiction du réseau et les annotations de l’expert. De manière plus précise,

Entrées¶

Les données d’entrée sont réparties en deux dossiers :

- Le dossier Images contenant un ensemble d’images préférentiellement au format jpg,

- le dossier Annotations se composant de fichiers TEXTE, un par image, contenant les annotations expertes, i.e. une liste de coordonnées matérialisant des boites rectangulaires représentant la localisation des objets d’intérêt vus par l’expert ; ces fichiers sont automatiquement produits par l’utilitaire AD-Annotator, et suivent une syntaxe spécifique : chaque ligne décrit un rectangle ou boite englobante d'une annotation par l’abscisse et l’ordonnée de son point inférieur gauche, sa largeur et sa hauteur, et le nom de la classe à laquelle il appartient.

Sorties¶

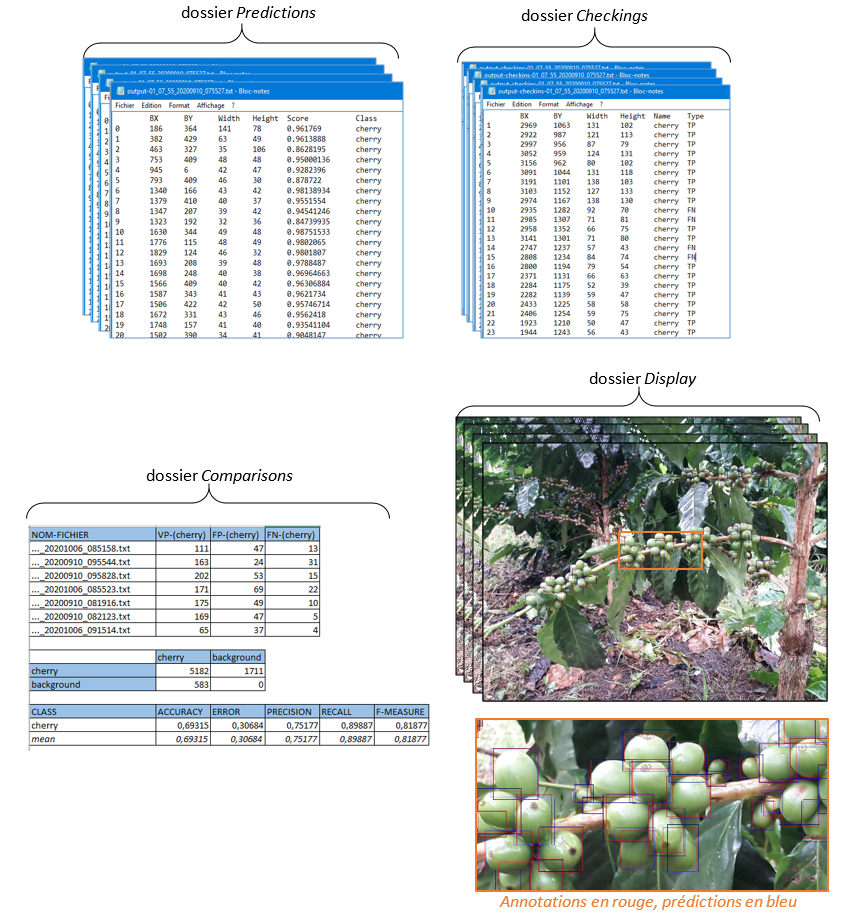

Les résultats sont répartis en quatre dossiers :

- Le dossier Prédictions

il se compose de fichiers TEXTE, un par image, contenant les prédictions du réseau, i.e. une liste de coordonnées matérialisant des boites rectangulaires représentant la localisation des prédictions dans l’image ; le score donné pour chaque boite représente la probabilité d’appartenance à la classe indiquée estimée par le réseau.

- Le dossier Checkings

il se compose de fichiers TEXTE, un par image, contenant le résultats du couplage Annotations / Prédictions, i.e. la liste des éléments constituant les classes Vrais Positifs, Faux Négatifs et Faux Positifs de l’étape qui permettront d’évaluer les performances du réseau. Ces fichiers permettent de contrôler les Annotations expertes et rechercher visuellement les similitudes des erreurs d’appréciation commises par le réseau. A utiliser exclusivement avec l’outil de control AD-Checker.

- Le dossier Display

Il se compose d’images JPG, une par image native, contenant l’incrustation des annotations expertes en rouge et des prédictions du réseau. Ces images permettent une appréciation visuelle rapide du travail de prédiction du réseau et permet d’appréhender les classes de couplage : les couples rouge-bleu correspondent aux Vrais Positifs, les boites isolées aux Faux Négatifs, et les boites bleues isolées aux Faux Positifs.

- Le dossier Comparisons

Il contient un unique fichier qui fournit

- Le nombre de Vrais Positifs, Faux Positifs et Faux négatifs, image par image

- La matrice de confusion, importante notamment pour dissocier les erreurs de détection des erreurs de classification dans le cas des réseaux multi-classes

- La valeur des indicateurs de performance du réseau, notamment le F-mesure, la Précision et le Rappel qui permettront de comprendre l’origine des erreurs des réseaux et de ce fait de suggérer des pistes pour améliorer significativement leur résultat.